Hinter geschützten Mauern – clevere und sichere Hochschullösung?

Generative Künstliche Intelligenz wie ChatGPT ist im Hochschulalltag angekommen – etwa beim Texten, Übersetzen und Codieren. Doch beim Umgang mit sensiblen Daten sind Vorsicht und rechtliche Klarheit gefragt. Das Schweizerische Institut für Informationswissenschaft testet daher eine eigene Lösung auf Basis Künstlicher Intelligenz, die Datenschutz gewährleistet und zugleich vielfältige Einsatzmöglichkeiten eröffnet.

Text: Caroline Dalmus, Norman Süsstrunk / Bild: FH Graubünden

Einen Text in eine andere Sprache übersetzen lassen, ein Abstract für den Forschungsantrag generieren, Inputs für die Datenanalyse einholen – die Verwendung von generativer Künstlicher Intelligenz (KI) wie beispielsweise ChatGPT ist im Arbeitsalltag von Wissenschaftlerinnen und Wissenschaftlern längst keine Seltenheit mehr. Sie bietet die Möglichkeit, viele Arbeitsschritte effizienter zu gestalten. Doch der Einsatz von KI birgt auch Konfliktpotenzial und vor dem Hintergrund der wissenschaftlichen Integrität haben insbesondere Hochschulmitarbeitende die Aufgabe, das eigene Handeln konsequent zu hinterfragen und dessen Folgen abzuschätzen. Denn Fakt ist: Durch die Eingabe von Informationen bei ChatGPT und Co. werden diese an Dritte weitergegeben, namentlich an die Anbieter der jeweiligen Plattformen. Dies mag weniger problematisch erscheinen, wenn es sich um eigene Texte handelt. Doch nicht selten hat man es im Forschungs-, Dienstleistungs- und Lehrkontext mit sensiblen Daten zu tun, bei denen die Weitergabe an Dritte als kritisch anzusehen oder sogar verboten ist. Dies gilt für Patientendaten bei Forschungsprojekten im Medizinalbereich genauso wie für Daten aus einer studentischen Bachelorarbeit. Um also Verstösse und unethisches Verhalten zu verhindern, müssen sich die Hochschulangehörigen der Problematik bewusst sein. Dabei ist auch die Unterstützung durch die eigene Institution wichtig. So stellt die FH Graubünden ihren Angestellten beispielsweise einen Leitfaden zur Verfügung, der sie insbesondere über die rechtlichen Rahmenbedingungen bei der Anwendung von KI in Forschung und Lehre aufklärt.

Doch was bedeutet das für den Arbeitsalltag an einer Hochschule? Kann generative KI nur begrenzt eingesetzt werden, nämlich dann, wenn kein Konfliktpotenzial besteht? Wer die Medienberichterstattung aufmerksam verfolgt hat, wird diese Frage mit nein beantworten können. Denn ein Beispiel aus der Bundesverwaltung zeigt, wie der Umgang mit sensiblen Daten gelöst werden kann. So wurde im März dieses Jahres berichtet, dass der Bundesrat eine KI-Anwendung namens Gov-GPT testet, die vom Bundesamt für Informatik entwickelt wurde. Dort werden alle Daten auf internen Rechnern verarbeitet, weshalb die Bundesrätinnen und Bundesräte auch vertrauliche Informationen eingeben können. Die Lösung liegt also darin, Daten gar nicht erst an Dritte (d. h. an die Anbieter von KI-Anwendungen) weiterzugeben, sondern ein System zu entwickeln, bei dem Daten institutionsintern gespeichert werden.

Eigenentwicklung für die Zukunft

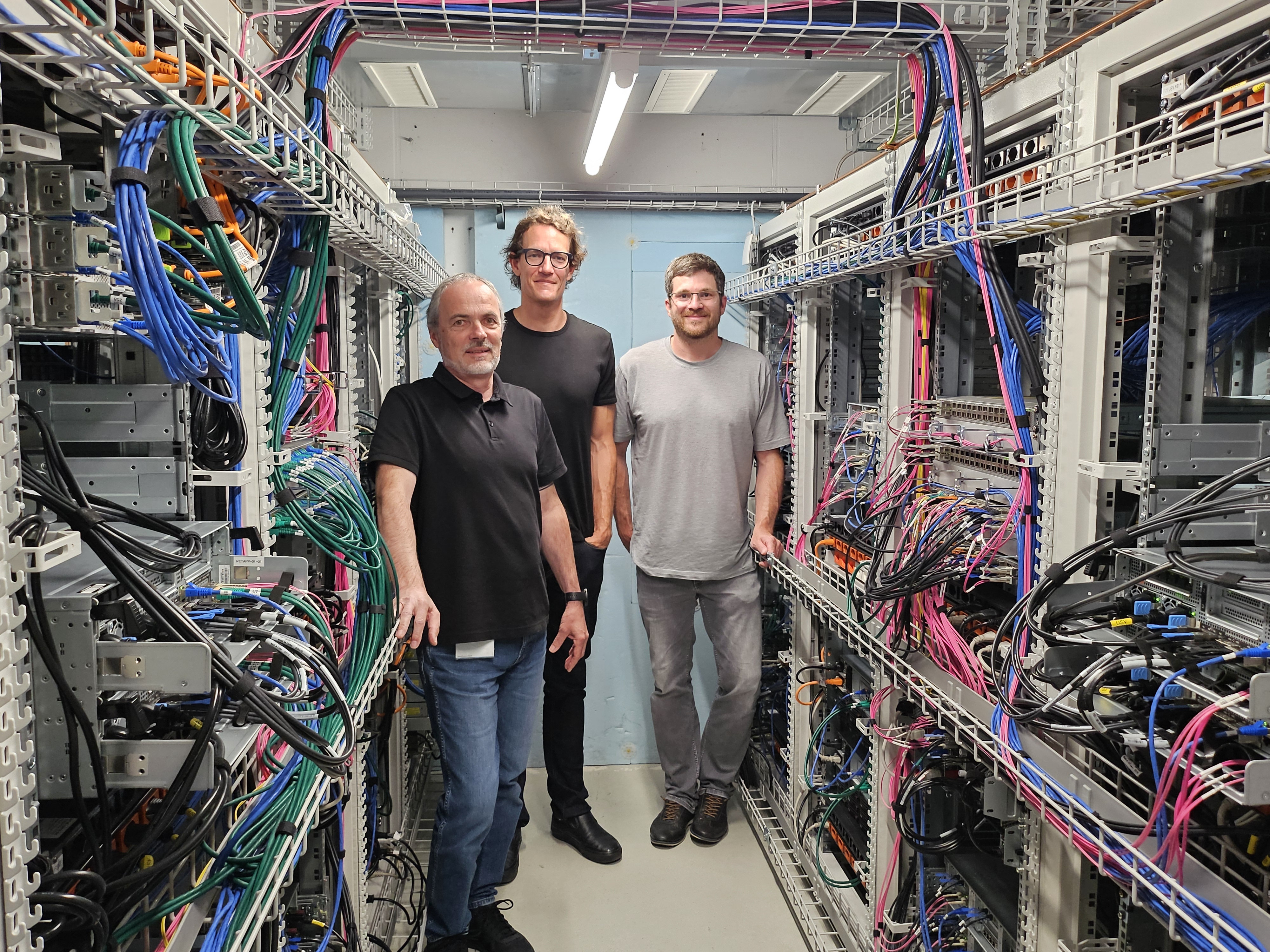

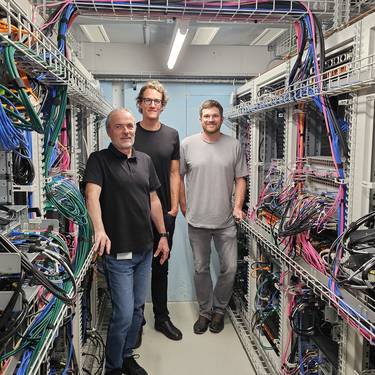

Von Bern zurück nach Chur. In Zusammenarbeit mit der IT-Abteilung der FH Graubünden haben Mitarbeitende des Schweizerischen Instituts für Informationswissenschaft eine Infrastruktur entwickelt, die von der Logik her wie Gov-GPT funktioniert. Für den Betrieb lokaler KI-Sprachmodelle wird ein Setup mit Ollama und OpenWebUI in einem Server-Verbund (Kubernetes) verwendet. Ollama ist ein Open-Source-Werkzeug, mit dem KI-Modelle wie Llama, Deepseek oder Gemma einfach zu installieren und zu benutzen sind. Man kann sich Ollama wie einen App-Store für KI-Modelle vorstellen: So wie man Apps auf sein Smartphone lädt, können mit Ollama verschiedene KI-Modelle in die Serverinfrastruktur geladen und genutzt werden. Der Serververbund besteht aus fünf Nodes (Servern), wovon zwei mit leistungsfähigen GPUs (Grafikkarten) ausgestattet sind. Diese GPU-Nodes werden gezielt für das Hosting der Modelle durch Ollama genutzt, um die Rechenlast effizient zu verteilen und die Ausgabegeschwindigkeit zu maximieren.

Was ist ein Kubernetes-Cluster?

Ein Kubernetes-Cluster ist ein System, mit dem Programme sich auf mehreren Computern automatisch gleichzeitig starten und steuern lassen. Anstatt eine Anwendung manuell auf jedem Computer zu installieren, übernimmt Kubernetes diese Aufgabe: Es verteilt die Anwendung auf die verfügbaren Geräte, sorgt dafür, dass sie immer läuft, und startet sie neu, falls etwas schiefläuft.

Ein Cluster besteht aus:

• einer Steuereinheit (Control Plane), die alles koordiniert,

• und mehreren Arbeitsknoten (Nodes), auf denen die Anwendungen tatsächlich laufen.

So können auch grosse, komplexe Anwendungen sicher und effizient betrieben werden – egal, ob in der Cloud, im Rechenzentrum oder lokal.

Insbesondere bei der Rechenlast stellt sich für Laiinnen und Laien die Frage nach den Ressourcen, die ein solches System benötigt. Denn dass KI Serverkapazität und Energie benötigt, ist hinlänglich bekannt. Doch auch hierfür gibt es Lösungen: Um limitierte Serverressourcen noch besser zu nutzen, können KI-Modelle verwendet werden, welche viel kleiner sind als Modelle wie GPT, aber trotzdem ähnliche Leistungen erbringen können. Das bekannteste Verfahren für die Entwicklung solcher kleinen Modelle ist die Modellkomprimierung. Hier werden grosse, bereits trainierte Modelle nachträglich verkleinert. Dies kann auf verschiedene Weise geschehen, etwa durch Quantisierung, bei der die numerische Darstellung der Modellparameter vereinfacht wird, oder durch sogenanntes Pruning, bei dem unwichtige Teile des Modells entfernt werden.

Auf die Probe gestellt

Momentan befindet sich die Infrastruktur der FH Graubünden noch in der Erprobung. Im Rahmen eines Testlaufs, bei dem Argumentationsmuster in Online-Kommentaren analysiert wurden, zeigte das System sowohl technisch als auch inhaltlich gute Resultate. So wurde die KI eingesetzt, um die Kommentare zu lesen und diverse Variablen zu codieren, zum Beispiel, ob ein Individuum persönliche Erfahrungen schildert, moralisch urteilt oder sich auf Fakten bezieht. Auch emotionale Tonlagen, Bewertungen sowie Pro- und Contra-Positionen wurden identifiziert. Selbstverständlich muss das System in weiteren Anwendungsfällen auf seine Leistungsfähigkeit getestet werden, etwa als Unterstützung beim Schreiben von Texten oder auch für Programmiertasks. Bewährt sich das Sprachmodell, kann in einem nächsten Schritt über einen breiteren Einsatz nachgedacht werden.

Beitrag von

Dr. Caroline Dalmus, Wissenschaftliche Projektleiterin, Schweizerisches Institut für Informationswissenschaft