Künstliche Intelligenz für die rätoromanische Sprache

Die Digitalisierung nutzen, um die rätoromanische Sprache national zu stärken – das ist die Motivation hinter «Translatur-ia». In diesem Forschungsprojekt zeigt die Fachhochschule Graubünden Potenziale und Herausforderungen auf, die während der Entwicklung von Sprach-Tools entstehen.

Text: Philipp Kuntschik / Bilder: Philipp Kuntschik, Lia Rumantscha / Übersetzung: Lia Rumantscha

Vor mehr als 80 Jahren wurde Rätoromanisch zur vierten Landessprache der Schweiz erhoben. Dennoch ist es selbst heute noch kaum möglich, sich auf nationaler Ebene adäquat auf Rätoromanisch zu informieren. Die Digitalisierung bietet die Möglichkeit, dies zu ändern. Das Projekt Translatur-ia der FH Graubünden entwickelt Methoden, um Anwendungen im Zusammenhang mit der rätoromanischen Sprache (z. B. Übersetzungsdienstleistungen) mithilfe von Computertechnologie zu optimieren. Gemeinsam mit der Lia Rumantscha ist es gelungen, einen Prototyp zu entwickeln, der zeigt, dass eine qualitativ gute Übersetzungshilfe trotz geringer verfügbarer Datenmenge umsetzbar ist. In zukünftigen Forschungsprojekten soll auf den gewonnenen Erkenntnissen aufgebaut und der Prototyp weiterentwickelt werden.

Moderne Methoden der künstlichen Intelligenz

Moderne Online-Übersetzungsprogramme erreichen durch die Anwendung neuronaler Netze bei weit verbreiteten Sprachen fast menschenähnliche Qualitätsniveaus. Bei diesem neuartigen Ansatz werden immense Datenmengen genutzt, um durch wiederholte Trainings ein Computermodell zu erstellen. Die Anwendung dieses Modells ermöglicht es anschliessend, in den trainierten Sprachen beliebige Texte zu übersetzen. Die Herausforderung im Fall der rätoromanischen Sprache liegt in der nur bedingt ausreichenden Menge an Daten; die konkrete Disziplin wird deshalb als «Low Resource Machine Translation» bezeichnet. Aktuelle Ergebnisse liegen in dieser Disziplin weit hinter vergleichbaren Resultaten stark vertretener Sprachen (bspw. Deutsch <> Englisch) zurück.

Die mathematischen Ideen hinter neuronalen Netzen sind dabei nicht neu und reichen bereits über 70 Jahre zurück. Jedoch erst durch den rasanten Anstieg an verfügbarer Rechenleistung in den letzten Jahren wurde es möglich, das Potenzial dieser Methoden in immer zahlreicheren Einsatzgebieten zu nutzen. Zu den Hauptanwendungsfeldern zählt heute neben der Bild- auch die Sprachverarbeitung und hier insbesondere die maschinelle Übersetzung. Die Anwendung von neuronalen Netzen unterscheidet sich dabei grundlegend von den klassischen Herangehensweisen im jeweiligen Anwendungsgebiet. Beruhte die klassische maschinelle Übersetzung auf dem manuellen Erstellen umfangreicher Grammatiken und ihrer Überführung durch viele ebenfalls manuell erstellte Regeln, so «lernt» ein modernes System die korrekte Übersetzung durch die Analyse zahlreicher Beispiele. Menschliche Interaktion ist dabei nur begrenzt erforderlich, dafür aber sehr viel Rechenleistung, da vereinfacht gesprochen «alle» Regeln ausprobiert werden.

Das System lernt, die Daten zu interpretieren

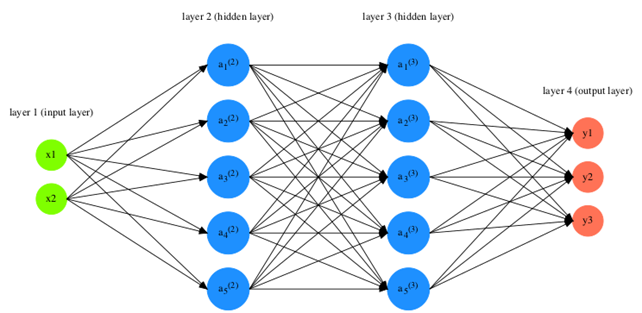

Technisch gesehen beschreiben neuronale Netze ein weitgehend selbstverwaltendes mathematisches Konstrukt, welches aus mindestens zwei Schichten besteht: Der Input-Layer ist für die mathematische Interpretation der Rohdaten zuständig, während der Output-Layer die Berechnungen des Netzwerks zu einem repräsentativen Ergebnis zusammenführt. Werden weitere «hidden layers» zwischen diesen beiden Schichten untergebracht, so wird von Deep Neural Networks (bzw. Deep Learning) gesprochen. Während des Trainings werden dem System Datenpaare gezeigt, welche sich aus den zu erwartenden Rohdaten (Input-Daten) und dem gewünschten Ergebnis (Label) zusammensetzen. Das Netzwerk versucht selbstständig, aus den Input-Daten ein Ergebnis zu erzeugen, vergleicht dieses mit den gewünschten Labels und nutzt anschliessend die festgestellte Abweichung zwischen Ergebnis und Erwartung, um die einzelnen Layer «rückwärts» zu kalibrieren (back-propagation). Über mehrere Iterationen hinweg «lernt» das System somit selbstständig, wie die Daten zu interpretieren sind, damit das gewünschte Ergebnis entstehen kann.

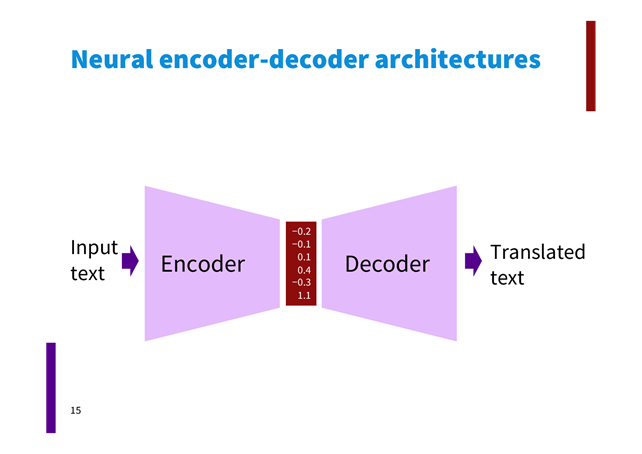

Die Komplexität eines solchen Systems bei Klassifikationsaufgaben ist weitgehend überschaubar, da meist alle möglichen Ergebniswerte bereits bekannt sind (beispielsweise True/False oder Kategorien wie a, b, ..., z). Geht es jedoch um die Manipulation oder Generierung von Inhalten (etwa bei Übersetzungsaufgaben), ist die Ergebnismenge virtuell unendlich. Die in solchen Fällen angewandte Encoder-Decoder-Architektur kann als Verkettung von zwei neuronalen Netzen verstanden werden, wobei das erste Netzwerk (der Encoder) einen mathematischen Vektor erzeugt, welcher gegebenenfalls manipuliert und anschliessend durch ein zweites Netzwerk (den Decoder) wieder in eine sinnvolle Sequenz umgewandelt wird. Die notwendigen Trainingsdaten bestehen dann ebenfalls paarweise aus Rohdaten und Zieldaten oder, im Fall einer Übersetzung, aus dem gleichen Satz in beiden Sprachen.

Daten, Daten, Daten

Die für die Entwicklung des Prototyps verwendeten Übersetzungsdaten wurden von der Lia Rumantscha und weiteren Wirtschaftspartnern zur Verfügung gestellt und aus dem Internet gesammelt. «Für die Zukunft der rätoromanischen Sprache ist es absolut zentral, dass der Übersetzungsprozess von Texten ins und aus dem Rätoromanischen beschleunigt werden kann», sagt Conradin Klaiss, Leiter Bildung bei der Lia Rumantscha. «Dadurch könnten mit demselben zeitlichen und finanziellen Aufwand mehr qualitativ hochstehende Texte generiert werden. Ausserdem dient dies der besseren Verständigung unter den Sprachgemeinschaften der Schweiz.» Um das Projekt weiter voranzutreiben, wurde eine Interessengruppe gebildet. Diese soll als Motor für die künftige Weiterentwicklung von Technologien und deren branchenspezifische Adaption dienen. Gesucht werden Text-Datensätze in Rumantsch Grischun und allen Idiomen, idealerweise mit einem Pendant in deutscher Sprache, sowie Anwendungsfälle, die vom Gebrauch rätoromanischer Sprachtechnologien profitieren würden. Anwendende sowie Interessierte sind eingeladen, sich bei der FH Graubünden oder der Lia Rumantscha zu melden.

Das Projekt wurde im Jahr 2020 durch den Förderverein der FHGR finanziert.

Beitrag von

Philipp Kuntschik, Wissenschaftlicher Mitarbeiter,

Schweizerisches Institut für Informationswissenschaften